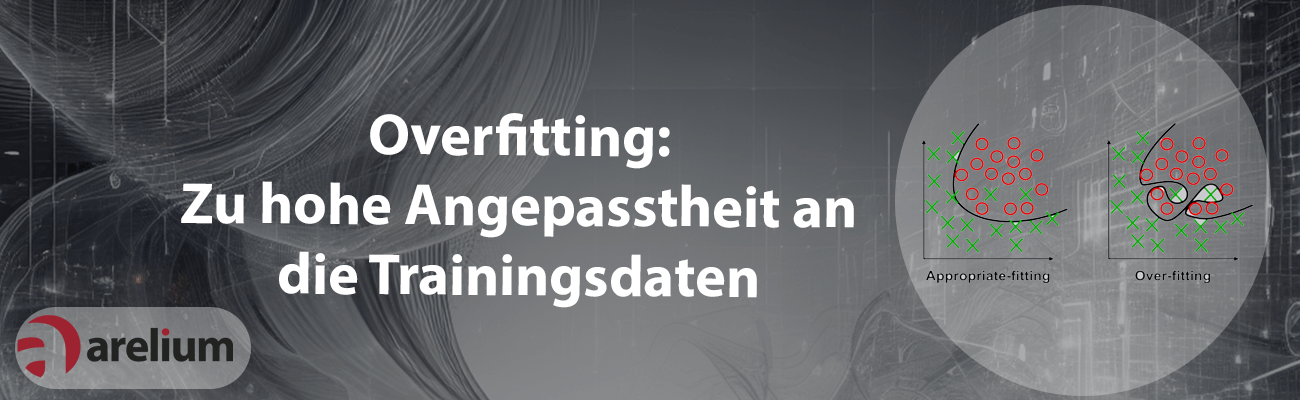

Overfitting ist ein häufiges Problem im Machine Learning, bei dem ein Modell zu stark an die Trainingsdaten angepasst wird. In der Folge verliert das Modell die Fähigkeit, auf unbekannten Daten zuverlässige Vorhersagen zu treffen, was seine Generalisierbarkeit beeinträchtigt. Eine der Hauptursachen für Overfitting ist die Berücksichtigung einer zu großen Anzahl von Merkmalen. Wenn das Modell zu viele Merkmale in die Analyse einbezieht, besteht die Gefahr, dass es sich an unwichtige Details und Ausreißer anpasst, statt allgemeingültige Muster zu erkennen. Ein weiteres Problem stellt eine zu geringe Menge an Trainingsdaten dar. Bei unzureichender Datengrundlage lernt das Modell die Trainingsdaten gewissermaßen „auswendig“ und überträgt die erkannten Muster nicht auf neue Daten.

Auch die Komplexität des Modells spielt eine entscheidende Rolle: Ein zu komplexes Modell besitzt zu viele Freiheitsgrade und neigt dazu, die Trainingsdaten zu überanpassen. Dies führt dazu, dass es zwar auf den Trainingsdaten eine hohe Genauigkeit erzielt, jedoch bei unbekannten Daten schlechtere Ergebnisse liefert. Fehlende Optimierungstechniken, wie etwa Regularisierung, tragen ebenfalls zum Overfitting bei. Regularisierung zwingt ein Modell dazu, einfachere und generalisierbare Lösungen zu finden, anstatt sich zu sehr an die Trainingsdaten anzupassen. Eine weitere wichtige Technik, die bei der Kontrolle von Overfitting hilft, ist Cross-Validation. Durch Cross-Validation lässt sich die Modellleistung auf unabhängigen Daten besser überwachen. Dabei wird sichergestellt, dass das Modell nicht zu stark an die Trainingsdaten angepasst wird.

Wie entsteht Overfitting?

Overfitting entsteht, wenn ein Machine-Learning-Modell zu komplex ist und sich zu stark an die spezifischen Details oder Ausreißer der Trainingsdaten anpasst. In solchen Fällen konzentriert sich das Modell darauf, die Trainingsdaten möglichst exakt nachzubilden. Anstatt also die zugrunde liegenden, generalisierbaren Muster zu lernen, folgt das Model genau den Trainingsdaten. Dadurch wird zwar eine hohe Genauigkeit auf den Trainingsdaten erreicht, jedoch leidet die Leistung auf neuen, unbekannten Daten.

Ein typischer Grund für Overfitting sind unausgeglichene Daten, bei denen bestimmte Klassen in den Trainingsdaten überrepräsentiert sind. Das Modell konzentriert sich dann übermäßig auf die dominierenden Klassen und vernachlässigt andere, weniger häufig auftretende Klassen. Auch zu viele Trainingsiterationen oder Epochen können Overfitting begünstigen. Wenn das Modell zu lange trainiert wird, passt es sich immer stärker an die spezifischen Eigenheiten der Trainingsdaten an, was die Generalisierung auf neue Daten verschlechtert.

Um Overfitting zu vermeiden, stehen verschiedene Methoden zur Verfügung. Eine verbreitete Technik ist die Regularisierung, die komplexe Modellanpassungen durch Strafen einschränkt und das Modell zwingt, einfachere, generalisierbare Lösungen zu finden. Eine weitere Methode ist Dropout, das vor allem bei neuronalen Netzen angewendet wird. Dabei werden während des Trainings zufällig einige Knoten deaktiviert, was die Abhängigkeit von einzelnen Merkmalen reduziert. Early Stopping ist ebenfalls eine effektive Strategie: Hier wird das Training gestoppt, sobald sich die Leistung auf einem Validierungsdatensatz nicht weiter verbessert. Auf diese Weise wird verhindert, dass das Modell zu stark an die Trainingsdaten angepasst wird.

Durch den Einsatz solcher Techniken lässt sich die Komplexität des Modells kontrollieren, die Generalisierbarkeit verbessern und das Risiko für Overfitting deutlich reduzieren. Das Modell bleibt dadurch besser in der Lage, zuverlässige Vorhersagen auf unbekannten Daten zu treffen.

In unserem Blogbeitrag erfahren Sie einen Vergleich zwischen Databricks und ML Studio.