Einleitung

In diesem Teil der Blogreihe werde ich über die ADF Komponenten und ihre Funktionsweise sowie Vergleichen zu SSIS und meinen anfänglichen Schwierigkeiten im Umgang mit der ADF erzählen. Bevor man allerdings in den Genuss kommt mit der ADF arbeiten zu können, muss diese zunächst im Azure-Portal angelegt werden.

Erstellen einer Data Factory

Das Erstellen einer Data Factory unterscheidet sich wenig bis gar nicht zur Erstellung anderer Ressourcen. Nachdem man den Menüpunkt zum Erstellen einer neuen Ressource ausgewählt hat, findet man die ADF in den Kategorien „Analytics“ oder „Integration“. Dann muss man der zu erstellenden Data Factory lediglich einen Namen zuweisen und diese einer Ressourcengruppe einer bestehenden Subscription zuordnen. Für die Version der Data Factory bevorzuge ich die Version V2, auf die ich mich auch in meiner Blog-Reihe beziehen werde. Aufrufen kann man die Azure Data Factory entweder über den Button „Author & Monitor“ innerhalb der Ressource im Azure-Portal oder über den Link adf.azure.com.

Nach dem Öffnen der Data Factory befindet man sich auf der Startseite. Von dort aus ist es möglich sich auszusuchen, ob man sein Projekt mit einer bestimmten Komponente wie einer Pipeline, einem Data Flow oder sonstigem beginnen möchte. Neben der Startseite kann man die Author Page oder die Monitor Page auswählen. Die Author Page ist im Prinzip der Hauptbestandteil der Data Factory und die eigentliche Entwicklungsumgebung. Die Monitor Page dient als Übersicht der Pipelineausführungen und fungiert als Fehlermonitor.

ADF Komponente

Wie eingangs bereits erwähnt hatte ich zu Beginn der Entwicklung mit der Azure Data Factory, trotz größter Euphorie und Vorfreude, das ein oder andere „Problem“. Meine Schwierigkeiten waren die, dass ich die Azure Data Factory stets mit SSIS verglichen und nach den selben Komponenten gesucht habe. An sich ist dies auch nicht falsch. Man muss sich jedoch darüber im Klaren sein, dass es mehr oder weniger die selben Komponenten sind, die aber einen etwas anderen Namen haben. Dazu aber im Folgenden mehr. Im Klartext: die ADF Komponenten sind gleich wie die SSIS Alternativen, heißen nur anders!

Pipelines

In der ADF ist eine Pipeline die Komponente, die ausgeführt wird um einen Prozess zu starten. In ihr wird der Kontrollfluss eines Prozesses sowie das Kopieren von Daten und Transformieren dieser Daten innerhalb eines Data Flows definiert. Somit ist eine Pipeline quasi mit einem Paket aus SSIS vergleichbar.

Activities

Ähnlich wie in SSIS gibt es auch in der Data Factory die Möglichkeit, verschiedene Tasks für ein Paket auszuwählen. Auch hier wird gewissermaßen zwischen Control Flow und Data Flow Tasks unterschieden. Nachdem man eine Pipeline erstellt hat befindet man sich quasi im Control Flow und hat die verschiedensten Activities zur Auswahl. Die Activities decken einen Großteil der bekannten Tasks aus SSIS ab und erweitern diese sogar. Beispielweise finden wir an dieser Stelle anstatt des Filesystem Task oder SQL-Task unter den Activities die Copy Data Activity oder Stored Procedure Activity sowie die Azure Function als Pendant zum Script Task und vieles mehr.

Data Flows, Datasets und Linked Service

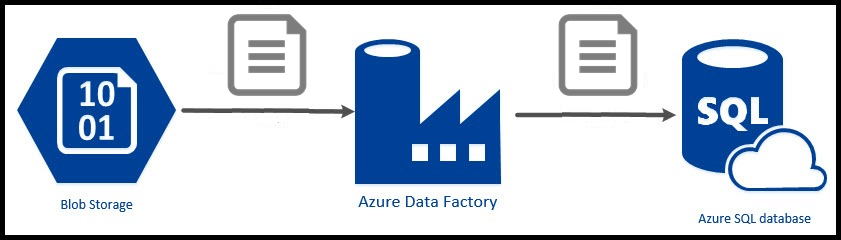

Ein Data Flow verfolgt in der Azure Data Factory die selben Ziele wie in SSIS und ermöglicht im Großen und Ganzen die Transformation von Daten ohne einen Quellcode schreiben zu müssen. Die Daten werden in Form von Datasets zur Verfügung gestellt. Diese sind mit den FlatFile-Quellen oder OLE-DB-Quellen bzw. Zielen in SSIS zu vergleichen. Ähnlich wie in SSIS im Connection Manager werden auch hier Verbindungen für diese Datenquellen benötigt. In der Data Factory werden diese Connections Linked Service genannt und ermöglichen den Zugriff eines Datasets auf die Daten des Linked Service.

Wie geht es weiter?

Im nächsten Teil der Blog-Reihe werde ich etwas genauer auf die einzelnen ADF Komponenten und ihre Funktionsweise eingehen. Dabei werden weitere Unterschiede und Gemeinsamkeiten auftreten und ich werde auf Neuerungen hinweisen.