PASS-Regionalgruppe Mittelrhein

Am Abend des 24. April 2020 hatte die PASS-Regionalgruppe Mittelrhein zu einem Vortrag geladen. Thema war die zeitgemäße Entwicklung moderner ETL-Prozesse mit Hilfe von Microsofts Azure Data Factory. Die aktuelle Corona-Krise zwang uns, diese Veranstaltung als Online-Event abzuhalten. Dies war jedoch Videokonferenztool TEAMS sehr komfortabel zu realisieren. Sicher lag es nicht nur an der Möglichkeit dem Vortrag somit gemütlich vom heimischen Sofa aus folgen zu können. Teilweise wurden bis zu 25 Teilnehmer registriert – ein Rekord in der Regionalgruppe.

Spannendes Thema

Viele Interessierte ließen sich schon durch den Titel der Veranstaltung begeistern. Das Thema „Azure Data Factory“ ist am Puls der Zeit und wer als Entwickler oder Entscheider in der Microsoft-Welt irgendwie mit größeren Datenmengen zu tun hat, kommt an diesem Trend zurecht aktuell nicht vorbei. Genau dies versuchten die beiden arelium-Mitarbeiter Christopher Münch und Torsten Ahlemeyer zu zeigen. In ihrer knapp 75 minütigen Session zeigten sie dies theoretisch aber auch am Praxisbeispiel. Im Anschluss entwickelte sich regionalgruppentypisch noch eine rege Diskussion. Die Fragerunde konnte qualifiziert alle Unklarheiten beseitigen. Des Weiteren wurden manche Erfahrungen aus dem Alltag eines Beraters und entsprechenden Kundenprojekten geteilt. An solch einer Veranstaltung nehmen Teilnehmer mit stark unterschiedlichen Vorkenntnissen teil, die diverse Rollen in einen sehr breiten Anwendungsszenario bekleiden. Neben Entwicklern sind auch Projektleiter, IT-Entscheider, Administratoren, usw… am Austausch beteiligt.

Frisches Referentenblut

Mit Christopher Münch hat ein arelium-Mitarbeiter seine Premiere als Referent gefeiert, der sich sehr gut auf der Entwicklerseite auskennt und schon lange in entsprechenden BI-Projekten eingesetzt wird. Er konnte neben seinem enormen Fachwissen auch immer kleine unterhaltsame Anekdoten aus dem „echten Leben“ einstreuen. Somit konnte er auch an Praxisbeispielen die Antworten auf Nachfragen verdeutlichen. Mit Torsten Ahlemeyer stand ihm schon in der Vorbereitung ein Senior zur Seite, der seit über einem Jahr als Sprecher auf Konferenzen auftritt. er unterstütze ihn mit manchen Tipps zum Referenten Dasein. Ähnlich wie die Vorträge „die Algorithmen hinter Facebook, XING und den Navigationsgeräten“ oder die Serie der Kopfnüsse mit Beiträgen wie „der T-SQL Sudoku-Löser“ gab es nur einen kurzen Erklärungs- und Einleitungsteil, dann ging es direkt in den Praxisteil über.

Eine durchgehende Demo mit Massendaten

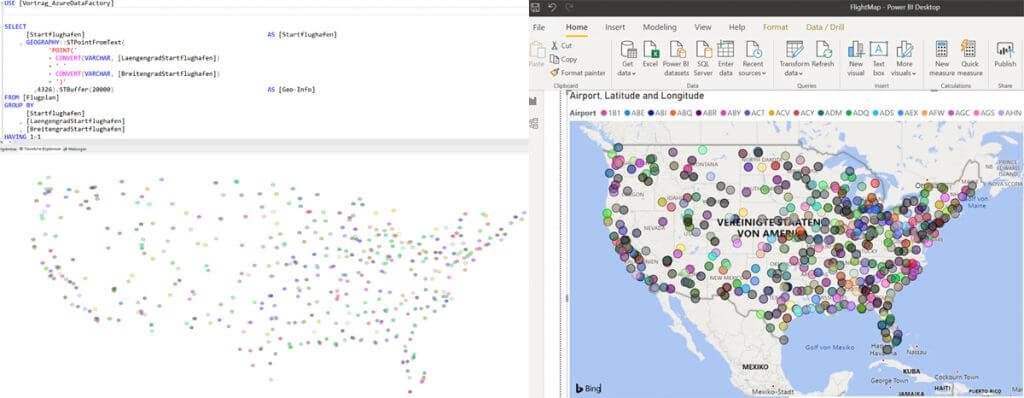

Die beiden Referenten hatten sich ihren Redebeitrag aufgeteilt, verwendeten aber über die ganze Session das selbe Beispiel mit identischer Datenbasis. Dazu hatten sie über die Plattform „kaggle.com“ über 3,5 Millionen Datensätze mit Flugbewegungen zwischen amerikanischen Airports organisiert. An diesem Muster zeigte erst Torsten Ahlemeyer den bisherigen Weg, die Daten aus einer CSV-Datei in den SQL-Server zu bekommen. Dies ist bei so einer Datenmenge jedoch nicht so einfach. Wenn dann noch das aufbereiten (Typenanpassung, Spaltenbennennung, …) und die grafische Ausgabe dazu kommt, dauert dies seine Zeit.

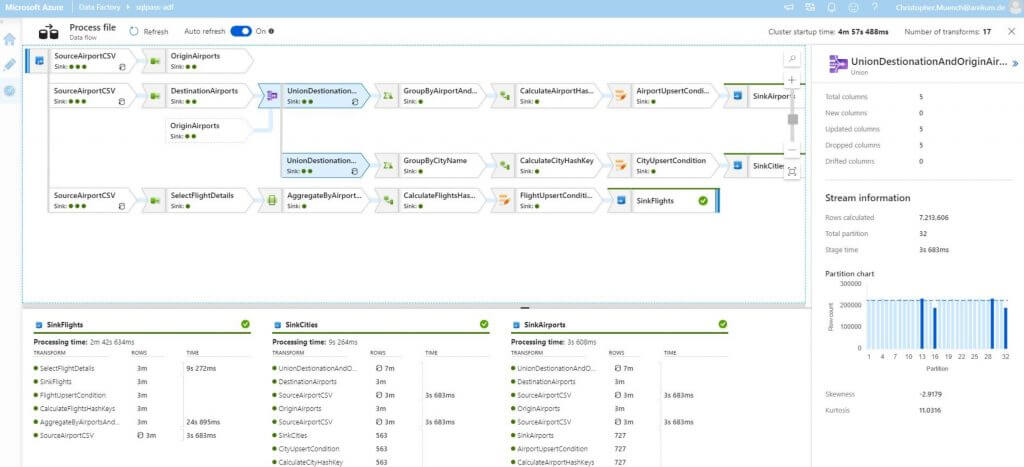

Kaum war dies erfolgreich absolviert übernahm Christopher Münch und demonstrierte, wie man die selbe Aufgabe mit heutigen Methoden effizient umsetzen kann. Hatte sein Kollege noch händisch Quellcode bereit stellen müssen, klickte er die entsprechenden Befehle durch Unterstützung einer grafischen Oberfläche zusammen. Aber nicht nur die Entwicklungsvorteile und -vereinfachungen kamen zur Sprache und wurden demonstriert. Auch die Prozesse „unter der Haube“ waren für die Teilnehmer sehr interessant. Spätestens als Christopher Münch zeigte, wie die Azure Data Factory selbstständig die Aufgabe in mehrere Partitionen zerlegte und auf den vorhandenen (virtuellen) Kernen gleichzeitig parallel ausführen konnte und so deutlich schneller zu einem identischen Ergebnis kam, lagen die Vorteile dieser Lösung auf der Hand.

Das bewegte die Teilnehmer

Die technische Lösung „Azure Data Factory (ADF)“ wurde schnell als überlegen akzeptiert. Im Anschluss entspannte sich jedoch ein reger Austausch, als es um die Frage ging, was diese Technologie denn kostet. Hier ist die Antwort alles andere als einfach, da sehr viele Komponenten in die Preisberechnung einfließen. Doch auch hier fand Christopher Münch klare Worte und stellte die Hilfen zur Verfügung. Diese stellt auch Microsoft seinen Kunden zur Verfügung, um sich im Vorfeld einen Eindruck von den Kosten für ein bestimmtes Szenario zu bilden. Hier gilt auf jeden Fall: Je besser man das eigene Projekt beschreiben kann, desto genauer wird diese Voraussage. Mit Tools wie dem offiziellen Preisrechner kann man dann sein Budget detailliert planen.

4 Kommentare. Hinterlasse eine Antwort

Guten Tag,

ein echt spannendes Thema… leider habe ich diese Session verpasst.

Gibt es davon eine Aufzeichnung?

Ich danke im Voraus.

Hallo Denis,

vielen Dank! Die Session wurde nicht aufgezeichnet, aber Christopher Münch und ich halten sie noch öfter. Die nächste öffentliche Gelegenheit gibt es am 28. Juli im Rahmen des „Semicolon“-Programms der GFU (Infos unter https://www.gfu.net/semicolon.html). Diese Session ist eine kostenlose Online-Veranstaltung, wird auch aufgezeichnet und bspw. auf Facebook übertragen. Christopher hat das Thema auch für die SQLdays im Oktober in Erding (https://sqldays.net/2020/) eingereicht. Hier gibt es sowohl persönlich vor Ort als auch remote per Liveübertragung die Möglichkeit ihm bei diesem spannenden Vortrag zu folgen. Auch diese Session wird aufgezeichnet.

Schöne Grüße aus Langenfeld,

Torsten Ahlemeyer

Hallo Torsten,

danke für die Hinweise, zur GFU angemeldet…

Bei den SQLDays sind die Themen aber noch nicht wirklich beschrieben oder habe ich etwas übersehen?

Viele Grüße

Denis

Hallo Denis,

gerne. Die Organisatoren der SQLdays haben wie viele andere Konferenzanbieter auch gerade keinen einfachen Job und müssen aufgrund der sich ständig ändernden Covid-19-Lage flexibel ihre Pläne anpassen. Der Call4Papers ist zwar schon vorbei, noch gibt es aber kein veröffentlichtest Programm. Mit den (potentiellen) Sprechern stehen sie aber in Kontakt und versuchen so schnell wie möglich Planungssicherheit herzustellen. Aber Du hast meine Antwort schon ganz richtig gedeutet: Der GFU-Termin ist bestätigt und wird stattfinden, für die SQLdays muss erst erstmal eine endgültige Zusage für den Sprechereinsatz geben…

Gruß

Torsten